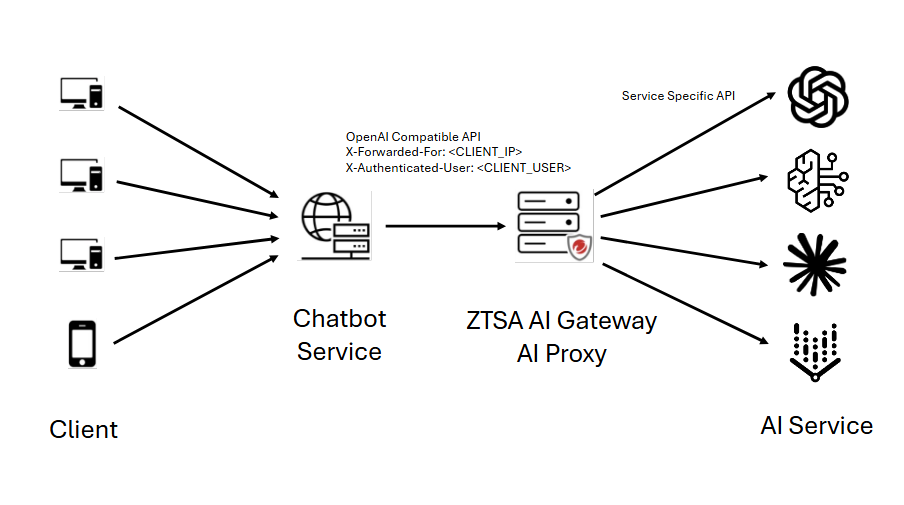

AI Proxy 是一種反向 Proxy,允許您使用多種大型語言模型(LLM)服務,並支援不同的 API 通訊協定。

您可以託管一個 AI 應用服務,該服務與多個自託管和開放的 LLM 互動,這些 LLM 具有不同的協議/模型。您可以添加內部部署閘道作為 AI Proxy,位於您的私人

AI 應用和這些多個 LLM 配置檔之間,以透過 AI secure access rule 和進階內容檢查來保護您私人 AI 應用或您託管的 LLM。

AI Proxy 模式允許您為受保護的私有生成式 AI 服務創建並應用 AI 安全存取和速率限制規則。內部部署閘道接收對您私有生成式 AI 服務的請求,並可以應用進階內容正在過濾、防止提示注入,以及透過

速率限制規則阻止潛在的拒絕服務攻擊。檢查過的請求可以根據內部部署閘道上的 LLM 配置文件轉發至個別 LLM 服務,當 LLM 服務返回回應至 AI Proxy 時,可以再次應用內容正在過濾,然後再將回應返回至您的私有生成式

AI 應用程式,接著到達端點或最終使用者

您可以使用 X-Authenticated-User 選項根據使用者設定存取控制。預設情況下,X-Authenticated-User 選項未啟動,且在 AI Proxy

模式下的內部閘道只能套用基於 IP 的 AI Secure Access Rules。

要使用此選項,必須由部署在內部閘道前方的下游應用程式插入 X-Authenticated-User 標頭。此 X-Authenticated-User 的值是最終使用者的

UPN 資訊。此 UPN 必須與用於建立基於使用者的 AI secure access rule 的使用者/群組相關聯。標頭的格式為:

X-Authenticated-User: example@domain.com

如果啟用了此選項,但下游應用程式未將標頭插入轉發流量中,則內部部署閘道會對此類流量應用任何基於使用者或 IP 的 AI secure access rule。

重要

|

建立 LLM 配置檔

在您將 AI Proxy 添加到您的閘道之前,您需要為每個您將要互動的 LLM 建立一個設定檔。

步驟

- 前往 ,然後部署新的內部部署閘道,或點擊現有內部部署閘道對應的編輯圖示 (

)。

)。 - 在「Gateways」標籤上,從「設定」功能表中選取「AI proxy」。LLM 設定檔頁面開啟。

- 點擊「Create profile」。

- 輸入設定檔名稱。

- 提供個人檔案的描述。雖然不是必須的,但這可能會很有用,特別是當您有多個版本的 LLM 時。

- 選擇 LLM 提供者。

- 設定 LLM 的設定。

- 按一下「儲存」。

- 對於您想要新增的每個設定檔,重複步驟3到8。

將 AI Proxy 新增至內部部署的閘道

一旦您建立了您的 LLM 配置檔,您就可以創建您的 AI Proxy 並將其添加到閘道中。

步驟

- 在上,點擊您想要使用AI Proxy的閘道的編輯圖示 (

)。

)。 - 在「進階設定」中,選擇「AI proxy」作為「Service mode」。預設的 HTTP 監聽埠是 8088。

- 如有需要,啟用 HTTPS 監聽。預設的 HTTPS 監聽埠是 8443。對於 HTTPS 請求,選擇使用預設的 SSL 憑證或提供具有私密金鑰和密碼的自訂憑證。

- 輸入「Protected app name」。

- 如果需要,您可以使用 X-Authenticated Users。

注意

這需要一個AI服務規則。欲了解詳細資訊,請參閱建立 AI secure access rule。 - 點擊「Manage profiles」。

- 選取您想要在AI Proxy中套用的LLM設定檔。

- 按一下「套用」。

- 如果需要,您可以點擊連接圖示來測試配置檔的連接性。然而,當您點擊「儲存」時,未測試的選定配置檔的連接性會自動進行測試。

- 按一下「儲存」。閘道已儲存,服務模式為AI Proxy。